The master thesis “Designing for Slow Reflection: Using a Physical Artifact to Reflect on Screen Exposure” was written by Dimitra Gkounta and Hasini Wijayantha, from the Master’s Programme in Human Computer Interaction and User Experience at the Umeå University in 2025. It explores how design can encourage people to think more deeply about their screen habits before going to sleep. In the current world, where most echnologies are designed to be fast and efficient, the authors experiment with slow technology; a design approach that promotes patience, reflection, and awareness instead of instant gratification.

Their research question is clear:

How can slow technology design qualities be implemented in an artifact to foster reflection on screen exposure before sleep?

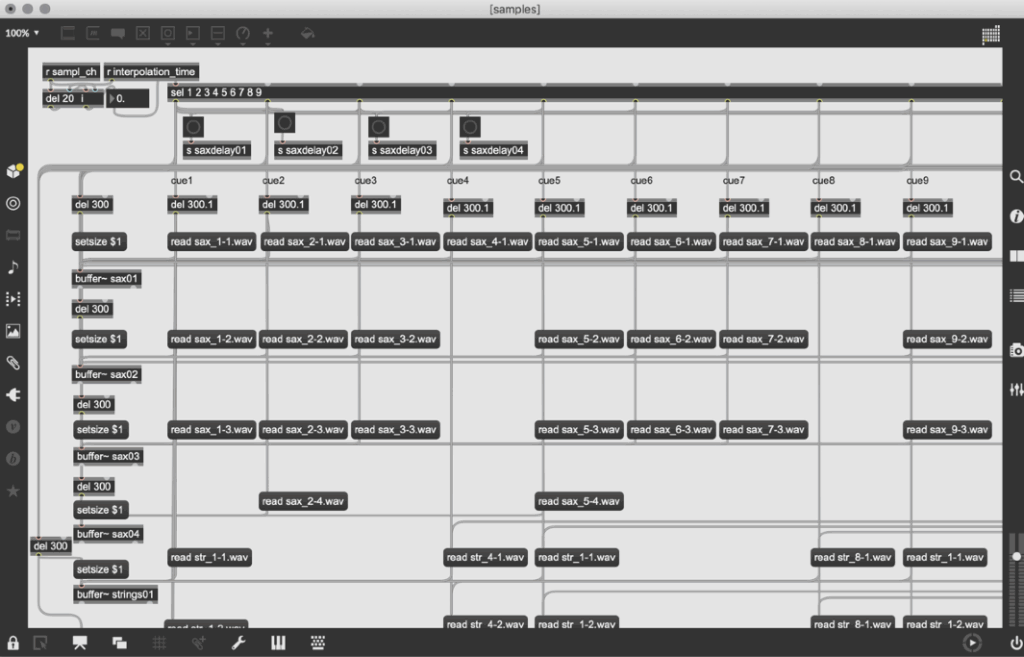

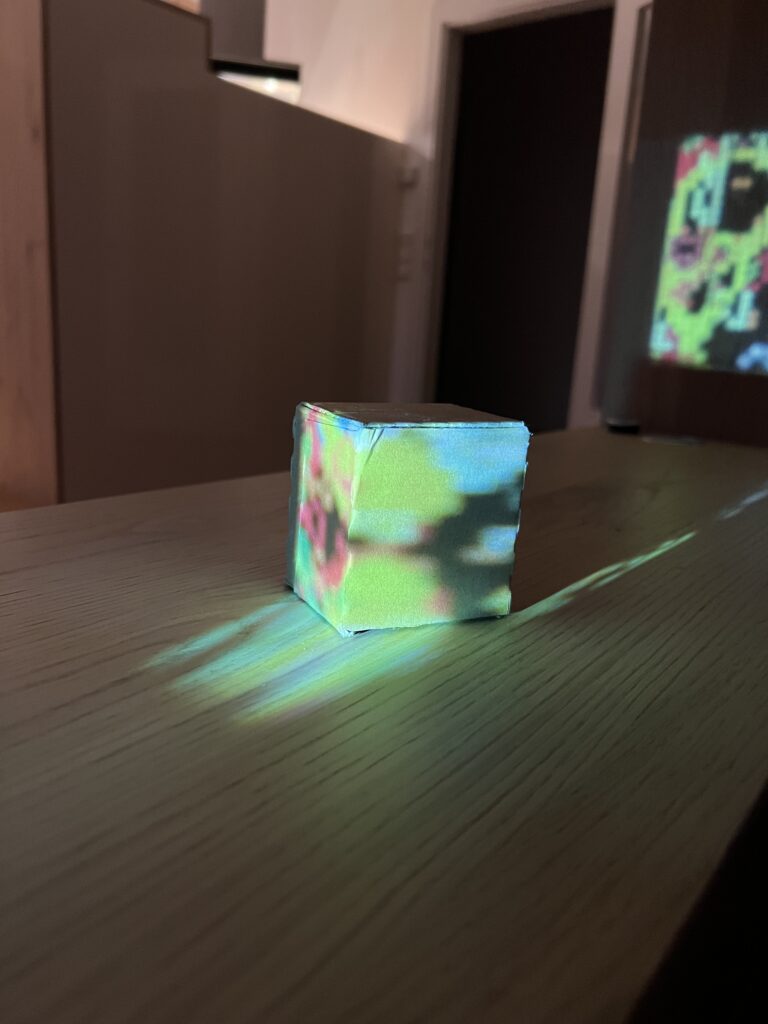

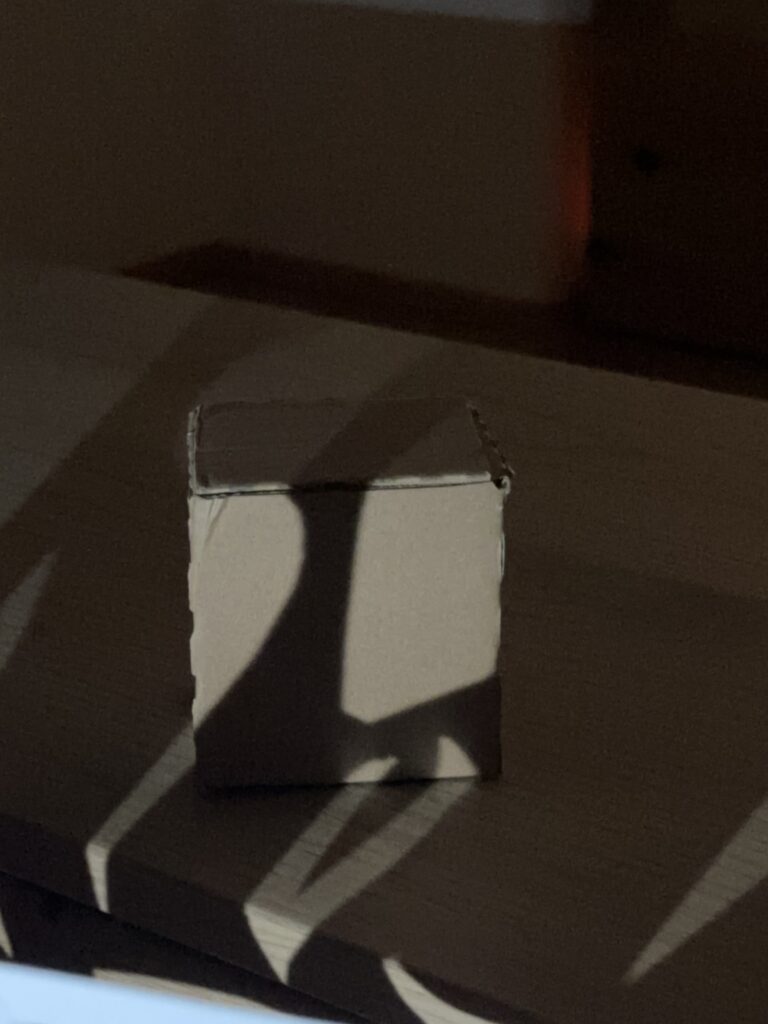

To explore this, they used a Research through Design approach and created a low-fidelity prototype figurine that changed it’s appearance based on participants self reported screen time and sleep quality over the span of three days. The figurine represented the users behaviour visually through torn clothes or dirt (representing poor sleep or excessive screen time) or a neat appearance (representing healthier habits).

Pre-Evaluation

The figurine is well documented in this thesis. The authors describe its material, design choices, and the reasoning behind each visual change, such as torn clothing or posture adjustments. Photos and diagrams show the figurine in different stages of transformation thus painting a clear picture of the development process. It is also explained why the figurine was kept low-fidelity, giving a very well documented impression overall.

Though it is not publicly accessible the detailed explanation of the process would allow an interested party to recreate a similar setup.

The theoretical arguments and the practical implementation align convincingly which can be seen by a clear representation of three slow technology qualities (explicit slowness, ongoingness, and pre-interaction). There is a deliberate delay between data reporting and visual change (explicit slowness), the figurines gradual deterioration (ongoingness), and the morning audio journaling (pre-interaction). Though some participants reacted poorly to the delayed feedback, that just confirmed the expected challenge of introducing slowness into an environment that is accustomed to fast-technology.

Overall the documentation is clear and comprehensible. Each methodological step is described in detail, easy to follow and participant quotes give quick insight into how the figurine was perceived.

In my opinion, the quality of this thesis fully meets the standards expected of a master’s thesis and could be used as a shining example. It demonstrates a strong link between theory and design, creative experimentation, and careful reflection.

Main Evaluation

Overall Presentation Quality

The thesis is professionally presented and well structured. There is a clear line leading from theory to practice and both the term slow technology and the design process of the figurine are explained well. The thesis reads very easily without loosing its scientific tone which was a pleasant surprise.

Degree of Innovation

I think this work is highly original, at least I haven’t seen anything similar before. It combines slow technology with self tracking through data which is very interesting. The delayed feedback approach was very new to me since most technologies focus on near instant feedback and quick responses. The figurine also introduced a certain ambiguity to the data which is a refreshing idea, hopefully leading to more meaningful engagement. Overall the thesis provided a fresh perspective by focussing on designing for reflection rather than efficiency.

Independence

The authors show strong independence and creativity. They designed and created the figurine themselves, developed the study setup, and critically reflected on their own design choices. And though it was not without its challenges (e.g. participant misinterpretation), they adjusted their method accordingly.

Organization and structure

This thesis is organized very logically. Each section builds upon the previous one and has a clear focus. The transitition from theory to practice is clear and the documentation of both design and analysis is easy to follow. Photos of the figurine add to an easily digestable reading experience.

Communication

The writing style is professional yet clear and easy to understand. Concepts like explicit slowness, ongoingness, and pre-interaction are well explained. In my opinion the authors successfully combined technical language with narrative elements such as participant quotes which made the whole thesis engaging to read.

Scope

The scope fits the level of a master thesis. The project focuses on a specific, manageable question and a small user group of six participants. My only critique would be that the study frame was very short (three days) and could’ve been expanded.

Accuracy and Attention to Detail

The study reads very careful and precise. The theoretical foundation seems solid and the design and analysis are documented in such detail, that it makes it easy to understand how the figurines transformations came about.

Literature

This thesis makes great use of literature by connecting classical theories of reflection (Schön, 1987) with more recent studies on slow design and personal informatics. The authors also situate their project in a broader research context by showing how their study fills a gap in applying slow technology in self-tracking before sleep.

Overall Assessment

This thesis was super interesting to read, gave plenty of new perspective, food for thought, and was overall a thoughtful piece of research. It had a strong theoretical foundation, a creative new concept and a more than sufficiently reflective analysis. I think the application of slow technology principles, through a physical figurine into personal informatics is innovative and refreshing and made for an engaging read. A minor weakness is the short duration of the study, which limits insight into long-term behavioral change and could question the validity of the study outcome. Still, this thesis offers some inspiration for designers/researchers who want to rethink the role of slowness and reflection in todays fast paced environment. Slowing down could actually help us see ourselves more clearly.