In diesem Artikel sollen folgende Fragen untersucht werden:

- Was ist eine audioreaktive Animation?

- Welche Funktionen bieten Blender und Cinema 4D?

- Welche Vorteile bietet diese Technik für ein Videomapping gegenüber einer herkömmlichen Animation?

Was ist eine audioreaktive Animation?

Eine audioreaktive Animation beschreibt den Prozess, bei dem ein Audiosignal von der Animationssoftware erkannt und als Information weiterverarbeitet wird, um bestimmte Parameter eines Objekts zu verändern. Ein einfaches Beispiel: Wird eine Kickdrum im 4/4-Takt mit 90 BPM (Beats Per Minute) erkannt, kann der entsprechende Frequenzbereich ausgewählt werden, um beispielsweise die Größe einer Kugel zu steuern. Die Skalierung der Kugel würde sich dann synchron zum Beat der Kickdrum verändern.

Die Herausforderung besteht darin, gezielt Einfluss auf die gewünschten Parameter wie Skalierung, Position oder Farbe zu nehmen und gleichzeitig dynamische Anschlags- und Ausklangszeiten zu definieren, um eine flüssige, ansprechende Animation zu erzeugen, die harmonisch mit der Musik interagiert.

Blender und Cinema 4D bieten hierfür unterschiedliche Ansätze und Werkzeuge, um audioreaktive Animationen umzusetzen.

Audioreaktive Animation in Blender mit Geometry und Simulation Nodes

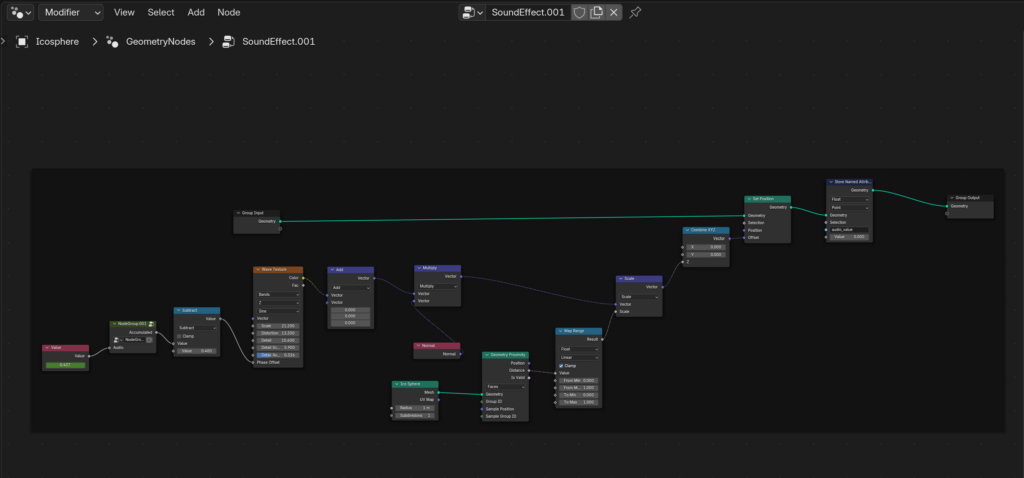

In Blender ermöglichen Geometry Nodes, 3D-Objekte prozedural zu erstellen, zu verändern und zu animieren, indem visuelle Knoten (Nodes) miteinander verbunden werden.

Ein häufiger Ansatz ist es, einen Keyframe auf einen Value Node zu setzen und diesen mit einer Audiodatei zu verknüpfen. Je nach ausgewähltem Frequenzbereich wird der Wert des Nodes dynamisch beeinflusst. So lassen sich die Eigenschaften eines geometrischen Objekts, wie Skalierung, Position oder Rotation, direkt durch das Audiosignal steuern.

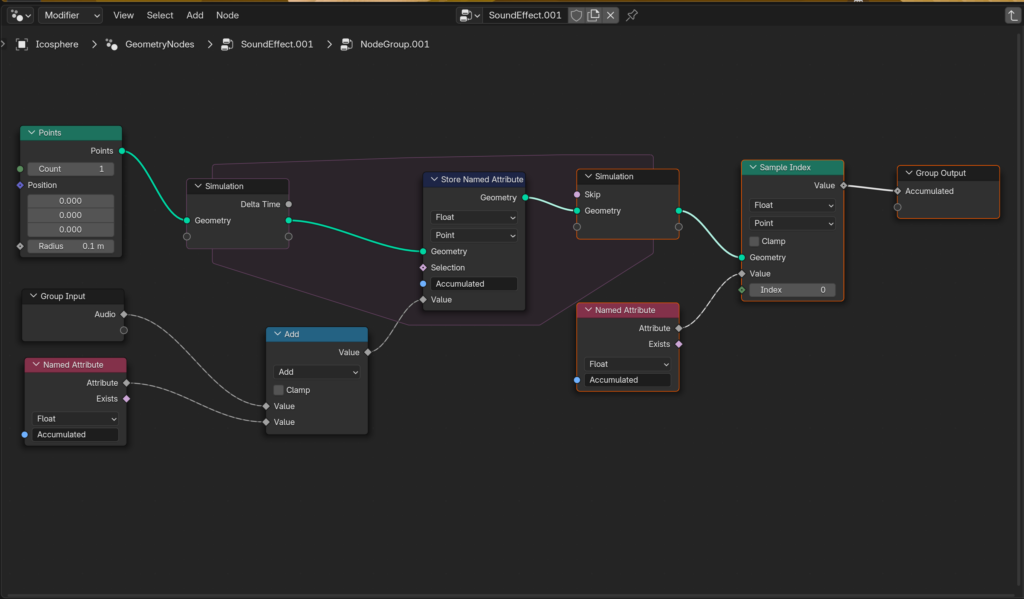

Besonders interessant sind die Simulation Nodes, die es ermöglichen, komplexe Bewegungen und Interaktionen zu generieren. Dies umfasst Loop-basierte Simulationen, die über mehrere Frames hinweg berechnet und präzise gesteuert werden können. Dadurch lassen sich flüssige Bewegungen und dynamische Ease-In- und Ease-Out-Animationen erzeugen, die nahtlos auf Audiosignale reagieren.

Tutorial für Blender:

Blender Audio-Reaktive Animation – Geometry Nodes Tutorial

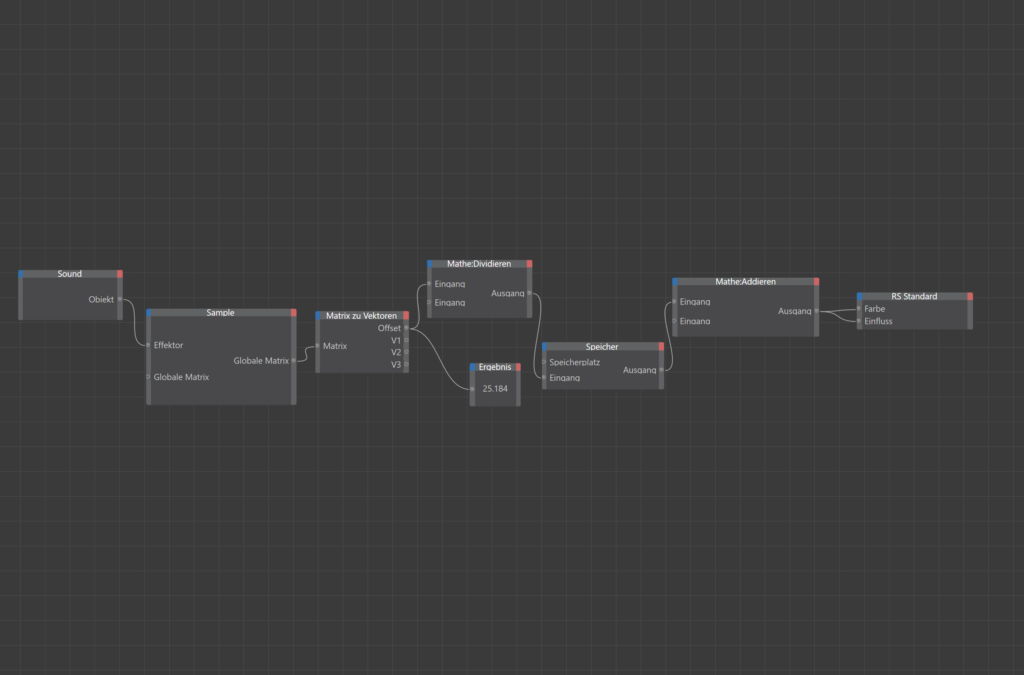

Audioreaktive Animation in Cinema 4D mit Soundfields und Mograph

Cinema 4D bietet mit seinen Soundfields und Mograph-Tools eine benutzerfreundliche Möglichkeit, audioreaktive Animationen zu erstellen.

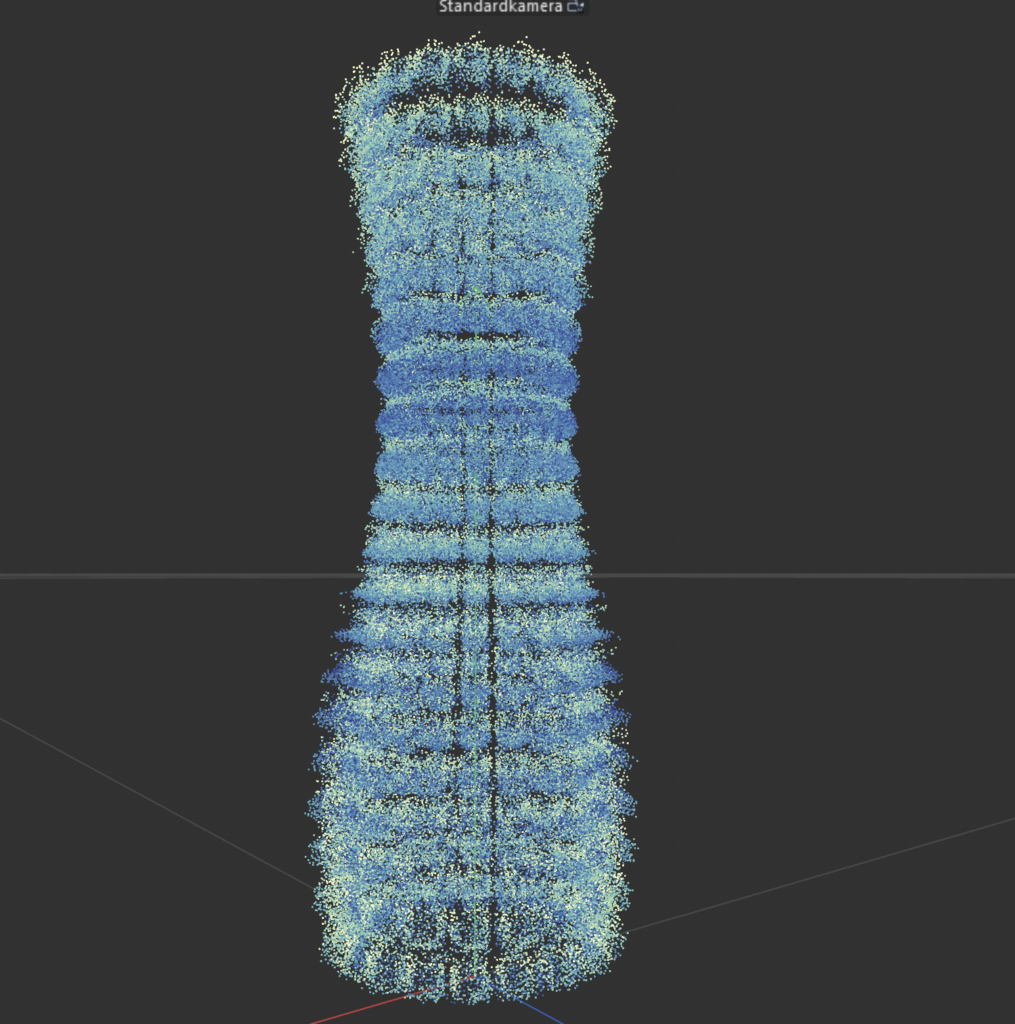

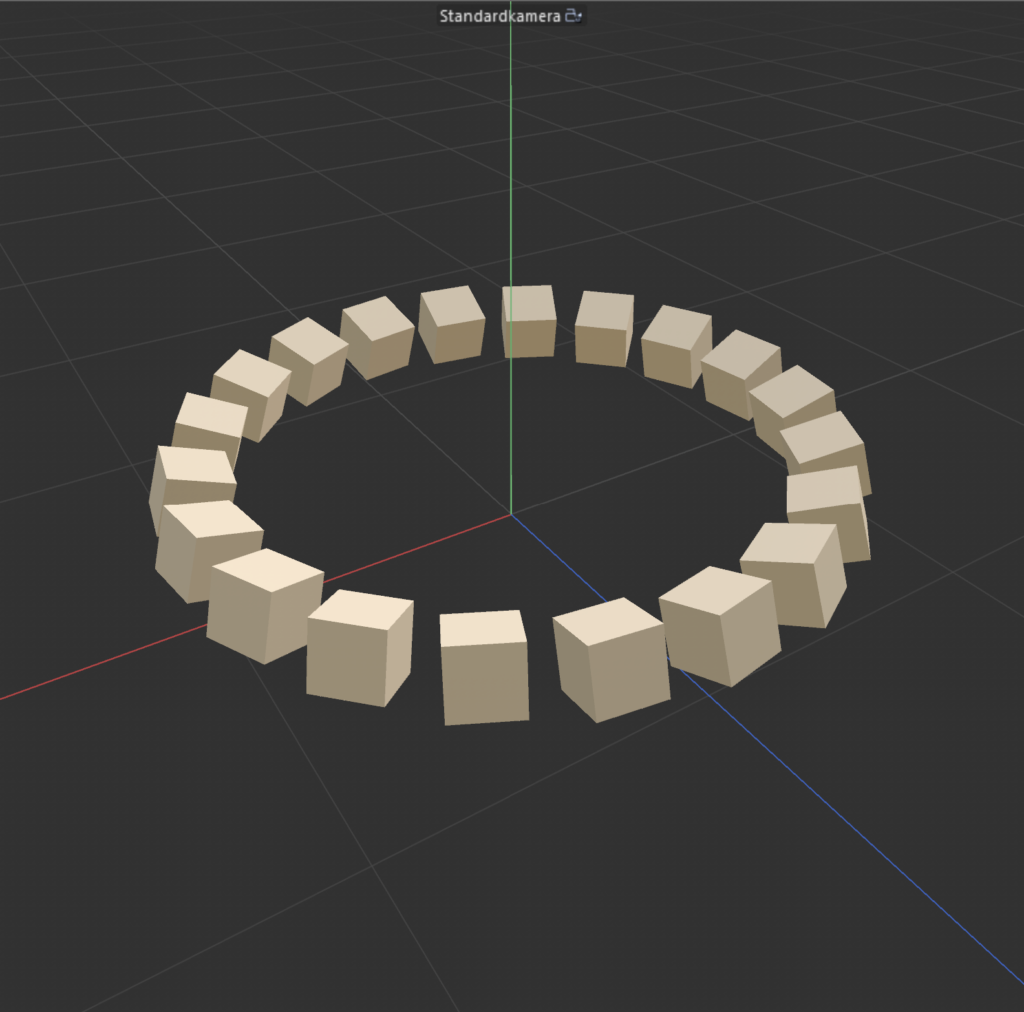

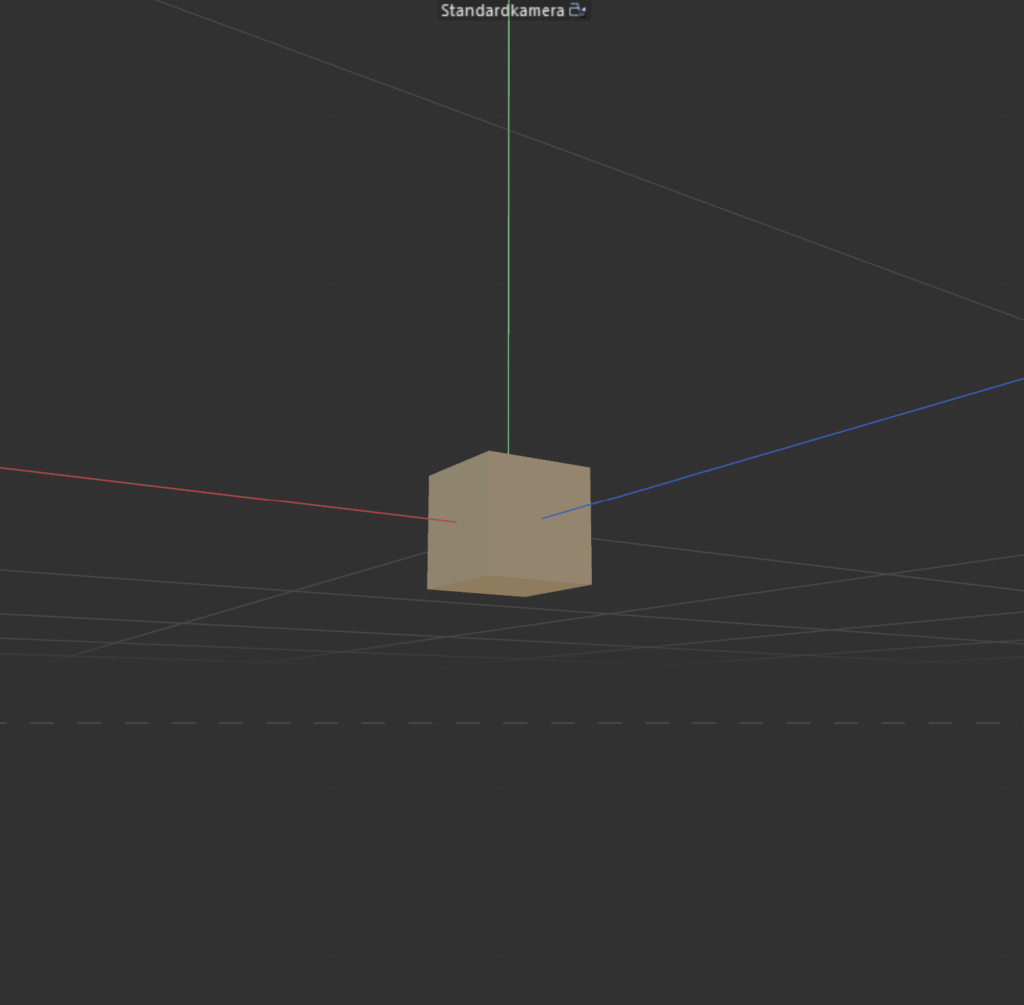

In meinem Beispiel wird ein Cube mehrfach geklont und über einen Schritt- und Formeleffektor, die beide ein Soundfield enthalten, animiert. Die Klone werden dann als Simulationsobjekte definiert, um eine Partikel-Replikation des ursprünglichen Turms zu erzeugen.

Das Soundfield ermöglicht es, Audiosignale direkt auf Parameter wie Position, Skalierung oder Rotation zu übertragen, was besonders für rhythmische oder abstrakte Animationen nützlich ist.

Vorteile für ein Videomapping gegenüber herkömmlichen Animationen

Im Kontext des Videomappings bieten audioreaktive Animationen erhebliche Vorteile, insbesondere bei der Gestaltung von längeren Visualisierungen, da sie zum Großteil ohne Keyframes auskommen und die Musik den Rhythmus vorgibt.

Ein besonderer Vorteil zeigt sich, wenn das Sounddesign selbst entwickelt wird. In diesem Fall entsteht eine einzigartige Symbiose zwischen Bild und Ton. Durch gezieltes Komponieren und das Einsetzen bestimmter Sounds und Frequenzen übernimmt der Sounddesigner gewissermaßen auch die Rolle des Animators.

Warum diese Technik besonders für Videomapping geeignet ist:

- Echtzeit-Reaktion: Visuelle Effekte können live auf Musik reagieren.

- Effizienz: Keine manuelle Anpassung von Keyframes erforderlich, die Animation passt sich dynamisch an.

- Kohärentes Erlebnis: Durch die direkte Verbindung von Ton und Bild entsteht ein intensiveres visuelles Erlebnis.

- Flexibilität: Änderungen im Audiosignal erfordern keine zeitaufwendige Anpassung der Animation.

Blender featuring C4D – Ein möglicher hybrider Workflow für die Zukunft?

Eine vielversprechende Methode, die Stärken beider Programme zu kombinieren, wäre der Einsatz von FBX, OBJ oder Alembic-Dateien, um Meshes und Animationen, die in Blender mit Simulation Nodes erstellt wurden, in den Workflow von Cinema 4D zu integrieren, um dort weiterverarbeitet zu werden.

So lassen sich die prozeduralen und simulationsbasierten Möglichkeiten von Blender mit den intuitiven Tools und der Benutzerfreundlichkeit von Cinema 4D verbinden, um ein noch leistungsfähigeres Setup für audioreaktive Animationen zu schaffen.

🤖🧠Disclaimer zur Nutzung von Künstlicher Intelligenz (KI):

Dieser Blogbeitrag wurde unter Zuhilfenahme von Künstlicher Intelligenz (ChatGPT) erstellt. Die KI wurde zur Recherche, zur Korrektur von Texten, zur Inspiration und zur Einholung von Verbesserungsvorschlägen verwendet. Alle Inhalte wurden anschließend eigenständig ausgewertet, überarbeitet und in den hier präsentierten Beitrag integriert.